人工知能AIは、差別をするのか。

人口知能が社会の隅々に広がるにつれて、社会にもたらされるのは混乱だけでなく差別もだという危惧が広がっている。

例えば、声の認識技術はアメリカ人男性によってのみ開発されたため、それ以外のアクセントを持つ声を差別する傾向がある。したがって、AIの開発チームは、多様性を考慮して開発・テスト過程に取り組むことが重要である。

AI革命の初期段階の今でさえ、多くのAIによる差別が実際に起こっている。

例えば、ある掃除ロボットが布団の上で寝ていた韓国人女性の髪の毛を傷つけてしまったことは、人間が床で寝るということをロボットが分かっていなかったから起きた。アメリカのある警察の監視カメラは、白人のアメリカ人よりもアフリカ系アメリカ人を特定することが正確でないと判断した。また、マイクロソフトが開発したチャットボットは人種・性差別的な発言をし始めている。さらに、東アジアと西洋で開発されたアルゴリズムは、それぞれの地域の人間を認識することがずっと得意であると分かっている。

これらのケースでは、開発やテスト過程で多様性の問題が起こるだろうという予測が十分にされず、特定の集団が他より有利な状況を生み出している。

AI差別を防ぐには・・・

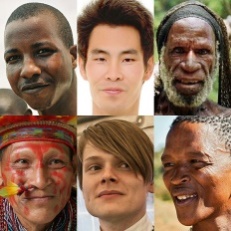

多様なメンバーにより構成された開発・テストチームであれば、差別的なAI製品ができることが少なくなるだろう。

チームのメンバーが、民族、性別、年齢、文化、伝統に宗教といった多様な特徴を表していれば、開発・テスト過程で組み込まれた異なる価値観や経験をもとに、AIはあらゆる視点を考慮して質問をするだろう(ベッドと布団のどちらで寝るかなど)。

男女、老若、異なる性的嗜好、アジア系、ヨーロッパ系、アフリカ系、および経済的、教育背景の違いを持つメンバーにより構成された多様な開発・テストチームを運営することは困難かもしれない。しかし、彼らの開発するAI製品はより差別が少なく幅広いターゲットにアピールし、世界的な大ヒットになる可能性が大いにあるだろう。